Klassifizierung im Maschinellen Lernen

- Josip Jerkovic

- 27. Feb. 2025

- 2 Min. Lesezeit

Aktualisiert: 4. Apr. 2025

Die Klassifizierung ist eine zentrale Aufgabe des überwachten Lernens, bei der Datenpunkte in vorgegebene Klassen eingeteilt werden. Ziel ist es, eine Funktion zu lernen, die Eingabedaten den korrekten Zielklassen zuordnet, wie etwa "Spam" oder "Nicht-Spam" in der E-Mail-Filterung. Dabei gibt es binäre Klassifikation (zwei Klassen) und Mehrklassenklassifikation (mehrere Kategorien).

Methoden der Klassifizierung

Lineare Modelle:

Logistische Regression: Nutzt die Sigmoid-Funktion, um Wahrscheinlichkeiten für binäre Klassen zu berechnen. Ein Schwellenwert (z. B. 0,5) entscheidet über die Klassenzuordnung.

Softmax-Funktion: Wird bei Mehrklassenproblemen verwendet, um Wahrscheinlichkeiten über mehrere Klassen zu berechnen. Jede Klasse erhält eine Wahrscheinlichkeit zwischen 0 und 1, die Summe beträgt immer 1.

Neuronale Netze:

Aktivierungsfunktionen wie Sigmoid (für binäre Klassifikation) oder Softmax (für Mehrklassenprobleme) sind entscheidend in der letzten Schicht neuronaler Netze. Sie wandeln Rohwerte (Logits) in Wahrscheinlichkeiten um.

Beispiel: Bei einem Bildklassifikationsproblem weist Softmax dem Bild Wahrscheinlichkeiten für jede mögliche Klasse (z. B. Katze, Hund, Pferd) zu.

Baumbasierte Modelle:

Entscheidungsbäume und ihre Erweiterungen wie Random Forest oder Gradient Boosting eignen sich für sowohl binäre als auch mehrklassige Probleme und liefern oft robuste Ergebnisse.

Probabilistische Modelle:

Naive Bayes nutzt bedingte Wahrscheinlichkeiten zur Klassenzuordnung. Es ist effizient, macht jedoch starke Unabhängigkeitsannahmen zwischen den Merkmalen.

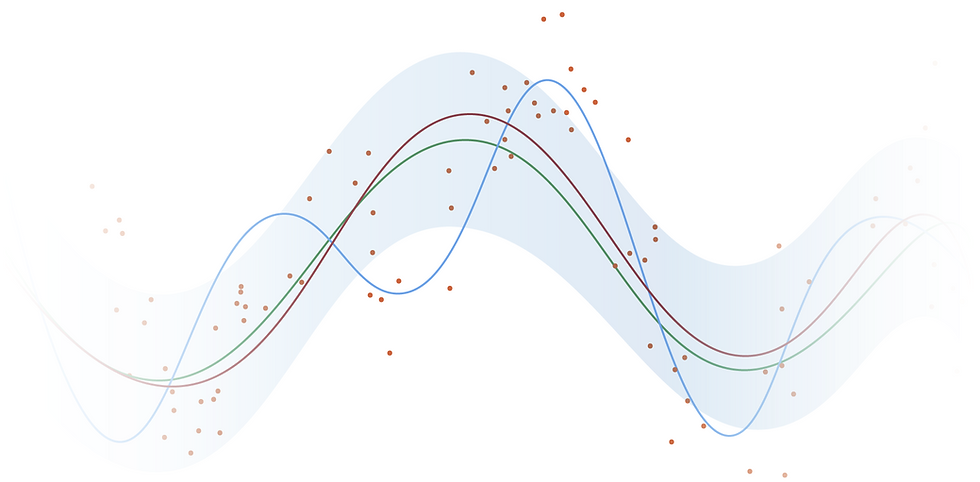

Beispiel eines Probabilisten Models

Eine Punktewolke soll in zwei Klassen unterteilt werden. Obwohl die korrekten Klassen bekannt sind, soll der Computer eigenständig die Klasseneinteilung vornehmen. Gaussian Mixture Models (GMMs) versuchen, n-dimensionale Normalverteilungen über die Punktewolke zu legen.

Der Vorteil besteht darin, dass für neue Punkte die Wahrscheinlichkeiten ihrer Zugehörigkeit berechnet werden können, da die Wahrscheinlichkeitsverteilung explizit modelliert wird. Dadurch eignet sich das Modell nicht nur für Klassifikationsaufgaben, sondern auch für Dichteschätzungen und Anomalieerkennung. GMMs sind besonders effektiv, wenn die Daten einer Mischung aus überlappenden Verteilungen folgen, da sie Cluster unterschiedlicher Form und Größe erfassen können. Die Methode bietet zudem Flexibilität bei der Modellierung komplexer Datenstrukturen und ist in vielen Dimensionen einsetzbar.

Metriken und Evaluierung

Die Leistung eines Klassifikationsmodells wird mit Metriken wie Genauigkeit, Präzision, Recall, F1-Score und ROC-AUC gemessen. Diese helfen, die Stärken und Schwächen eines Modells, insbesondere bei unausgewogenen Datensätzen, zu beurteilen.

Herausforderungen und Anwendungen

Zu den Herausforderungen zählen unausgeglichene Klassenverteilungen, verrauschte Daten und Overfitting. Methoden wie Regularisierung, Datenaugmentation und Cross-Validierung helfen, diese zu bewältigen. Klassifikationsmodelle finden breite Anwendung in Bereichen wie der medizinischen Diagnostik, Spam-Erkennung, Sentiment-Analyse und der Bilderkennung.

Zusammenfassend ist die Klassifizierung eine vielseitige Technik im maschinellen Lernen, deren Algorithmen durch Funktionen wie Sigmoid und Softmax präzise Entscheidungen ermöglichen.

Die KI-Blog Reihe

Teil 1: Künstliche Intelligenz

Teil 2: Klassifizierung im Maschinellen Lernen

Teil 3: Regression